インデックスとは、作成したWebページの情報が検索エンジンのデータベースに登録されることです。

ここでは、インデックスの概要や、より効果を出すための注意点などについて、詳しく解説していきます。

\検索エンジンの仕組みを含むSEOの基礎を動画で学びたい方はこちら!/

目次

インデックスとは検索エンジンのデータベースに登録されること

インデックスとは、検索エンジンのデータベースに、Webページが登録されることです。

インデックス(index)とは非常にさまざまなシーンで用いられる用語で、それぞれ異なる意味で使われます。本来インデックスとは「索引」「見出し」などの意味をもつ言葉です。

データベースに関わるシーンで用いられる際には、格納されたデータをより早く検索したり抽出できるように作られたりする索引データのことを言います。

SEOにおける「インデックス」とは、クローラーが収集したWebページのデータを検索エンジンデータベースに整理された状態で格納されることを指します。「インデックス化」「インデキシング」などといいます。

SEOでは常用語として「インデックス化される=インデックスされる」と表現しています(特にこのあたりの厳密な言葉の使い方に細かくこだわる必要はないとは思いますので当サイトでもその使い方で統一しています)。

実際には、検索エンジンクローラーがWebページのデータを収集した後に、そのままの形でインデックス化されるわけではありません。

「インデクサ」と呼ばれるプログラムによって検索エンジンにとって処理がしやすいデータに変換する中間処理が行われ、その変換されたデータがインデックス化されます。

SEO上での効果

検索エンジン上での露出を増やすにあたっては、何より公開したWebコンテンツが正しく検索エンジンにインデックスされていることが大前提にあります。データベースに登録された、つまりインデックスされたページが、検索結果に表示されているからです。

トップページに限らず、検索結果に表示されるページであればどんなページでもユーザーにとっての入口になる可能性があります。そのため、ページ数が多い方が集客を期待できることになり、さまざまな検索キーワードを想定したSEO施策が重要になります。

しかし、いくらランキングを向上させるための施策を講じたところで、そのページがインデックスされておらず、そもそもランキングの対象になっていなければその施策に効果はありません。

ページ数の多いサイトはサイトの構造が複雑になったり、サイト階層が深くなったりしやすくなるため、クローラーが適切に(狙い通りに)クロールし、インデックスできるように配慮するのは必要不可欠です。

クローラーへの配慮をおろそかにした結果、せっかく公開したページがなかなかインデックスされなかったり、正しく認識されなかったりすることは珍しいことではありません。

例えば、大学受験生がいくら頑張って受験勉強を行ったところで、願書の提出を忘れてしまったら、どんな大学でも不合格どころか受験資格すらありません(※筆者経験談)。

検索エンジンも同様に、まずはWebページを正しくインデックスさせられる、ということがSEOの大前提になります。

この記事もチェック

Google検索におけるインデックスの流れ

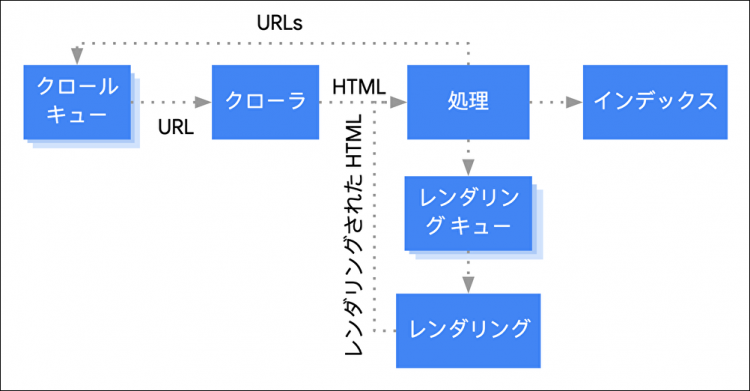

国内の利用者が最も多いGoogle検索ではどのようにインデックスされるのでしょうか。流れを確認しましょう。

画像引用元:JavaScript SEO の基本を理解する | Google 検索セントラル | Google Developers

基本的な流れとしては、1. クロールキュー(検出)→2. クロール→3. レンダリング→4. インデックスと押さえておけば大丈夫です。

1. クロールキュー(検出)

前提として検索エンジンはページをURL単位で認識します。

例えば、末尾のスラッシュのありなしでも別のURLと認識します。そして、この検出のタイミングでクロールするURLを発見し、キューとして(イメージとしては)リスト化していきます。検出したURLに対しクロールしていくわけですね。

そのため、まずは検索エンジンがそのページ(URL)を見つけることができるようにするのがポイントです。

この際、内部リンク、外部リンクやXMLサイトマップが検出の主な手段となります。そのため、新規サイトや、内部リンクが設定されていない孤立したページなどは、検索エンジンがなかなか見つけられないということもあります。

2. クロール

検出したページ(URL)に対し、検索エンジンはクロールをしていきます。

詳しくは下記の参考記事を確認していただきたいのですが、クロールは「ページの情報を取得する」というイメージを持っていただければと思います。

よって、この際のポイントとしては検索エンジンがURLにアクセスできるようにrobots.txtで不要なクロールのブロックをしないことや、クロールの負担を減らすためにURLの正規化、不要なページを生成しないようにサイトの環境を整えることがポイントになります。

この記事もチェックしてみてください

3. レンダリング

検索エンジンはそのページをインデックスして問題ないかを判断するために、レンダリングという我々がブラウザでページを見るように描画する作業を行います。

2. クロールで取得したデータを元にページを描画していると考えていただけると良いかと思います。

この作業を行うことで視覚的にページ内容の把握や、表示できないリソースの存在の認識が可能になります。

なお、検索エンジンのJavaScriptを扱う性能は、基本的に最新版のChromeと同等であり、ブラウザで表示できる場合は検索エンジンも実行できるイメージでOKです。

しかし、すべてのサイトで無限にクロールすることはできず、各サイトにはクロールの割り振りが存在します。そのため画像などのリソースやページ表示に時間のかかるサイトではクロールやレンダリングにも影響が出る場合があります。

4. インデックス

1~3の工程を経てインデックスされることになります。

ただし、以下の場合は、インデックスされないこともあります。

- インデックスする価値のないページと判断された

- レンダリングが正常に行えなかった

- 重複ページやソフト404などのエラーと判断された

その場合はそれぞれ対応が必要になりますが、そもそもの認識を「検索エンジンはインデックスして当然である」と考えずに、インデックスされる価値のある問題のないページを目指していきましょう。

詳しくはこの記事をチェック!

\SEOで成果につなげる!資料ダウンロードはこちらから/

スムーズなインデックスを促すポイント

ページがインデックスされるためには、クローラーがページを認識しやすいように配慮することが大切です。

ここではスムーズなインデックスを促すポイントを紹介します。

XMLサイトマップを作成し、内部リンクを整える

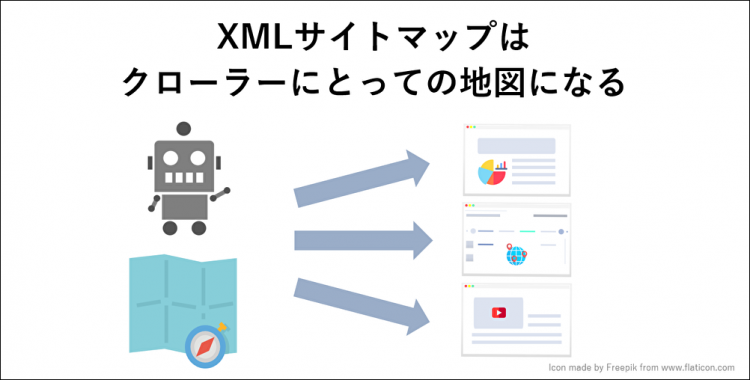

Webサイトにやってきたクローラーはリンクをたどってサイト内を巡回し、たどり着いたページをインデックスしていきます。

このとき、サイト内の構造がわかりやすくなっていると、ページからページへと巡回しやすくインデックスもスムーズに行われます。クローラーの巡回を手助けするのがサイトマップです。

サイトマップというと、ユーザーのためにサイト内のページ構造をわかりやすく一覧にしたページだと思われるかもしれません。そうしたユーザー向けのサイトマップは「HTMLサイトマップ」と呼びます。もちろんHTMLサイトマップを設置することも重要なのですが、実はサイトマップにはもう一つあるのです。それが、クローラーにサイトの情報を伝えるための「XMLサイトマップ」です。

XMLサイトマップは、サイトの更新日や更新頻度などを記載しておき、Webサイトと同じサーバに設置します。XMLサイトマップは、基本的にユーザーの目には触れません。XMLサイトマップを参照するのは検索エンジンのクローラーです。XMLサイトマップでサイト情報をクローラーに伝えることでインデックスを促す効果が期待できます。

とはいえ、基本的にはXMLサイトマップではなく、内部リンクこそが、クロールの重要なポイントです。

「そのページへの内部リンクが1つもない」という状態では、検索エンジンはそのページを検出しにくいだけでなく、ページの重要性も理解しにくくなります。

新規ページがサイトTOP、カテゴリーTOPに表示されるようにする、関連する記事では内部リンクを設定する、データベースサイトであれば、カテゴリーページやパンくずリストを適切に活用し、内部リンクが行き届くように心がけて下さい。

なお、XMLサイトマップは、Webサイトの規模がそれほど大きくない場合や、各ページが適切にリンクされている場合は不要です。

詳しくはこの記事をチェック!

ページタイトルを適切・簡潔にする

ページのタイトルとコンテンツ内容に整合性がないと、クローラーにとっては認識しづらくなります。

タイトルは短く簡潔なものにしつつ、コンテンツの内容を正しく表している文言になるようにしてください。

SEOのために関連キーワードを詰め込みすぎてタイトルが長くなると、検索結果で省略されてしまうので禁物です。ユーザーにとってわかりやすいタイトルが、クローラーにとっても認識しやすいと考えましょう。

画像や動画には代替テキストなどを適宜使用する

ページ内の画像や動画には、内容を示す代替テキスト(alt属性)を入れておきましょう。

例えば、画像だけで構成された商品ページなどは、各画像に代替テキストを入れなければクローラーが認識できず、インデックスされない恐れがあります。

クローラーが認識できるのはあくまでテキスト情報であり、画像や動画の内容までは認識できません。テキストがあるページでも、画像ごとに適切な代替テキストを入れて、テキストとの整合性を取りましょう。

サイトの表示速度を高める

Googleのクローラーは、サーバーに負荷をかけないようにクロール頻度に上限を設けています。

クロールによって、サーバーに負荷をかけていると認識した場合、そのページへのクロール頻度を下げることがあります。クローラーによるクロール時間が短くなればサーバーへの負荷が低減するので、Webサイト側で表示速度がより早くなるようにしてあげましょう。

Webサイトをモバイル対応にする

今やユーザーの多くがパソコンよりもスマートフォンやタブレット端末でWebサイトを閲覧しています。ユーザーの閲覧傾向の変化に伴い、Googleもインデックスにおいてモバイルファーストを打ち出しています。

モバイル端末にも適したWebサイトになっているかも、スムーズなインデックス登録に不可欠な要因となっています。

Google Search ConsoleでURL再検査を行う

クローラーはリンクをたどって定期的に巡回し、インデックスを行います。そのため、リンクされていないページや公開して間もないページはなかなかインデックスされないことがあります。

そんなときは、インデックスを促すためにGoogle Search Consoleを活用しましょう。

まず、該当ページのURLがインデックスされているかどうかを検査します。Google Search Consoleを開き、「URL検査」を選択。該当ページのURLを入力して「テスト」ボタンをクリックすれば、そのページが現在インデックスされているかどうかがわかります。インデックスされていなければ、「インデックス登録をリクエスト」ボタンをクリックします。

インデックス数とSEOの関係

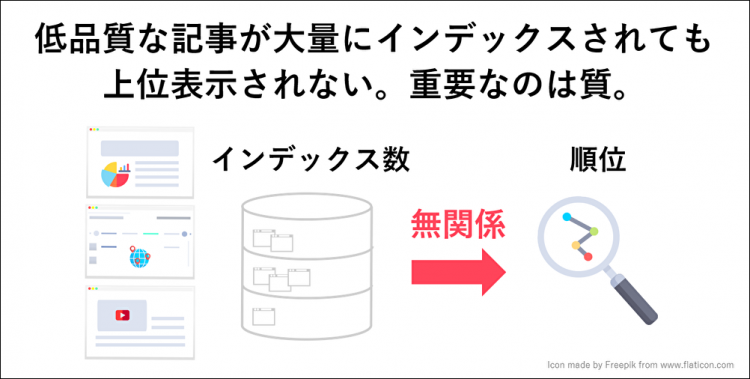

サイト内でインデックスされたページの数は多ければ多いほどSEO的に有利なのでしょうか。

インデックスされたページの数はSEOに影響はありますが、それはインデックスされるページが高品質であることが前提になります。

SEOで大事なのは「質の高いページ」がたくさんあり、インデックスされていることです。価値の低いページを大量に作り、すべてインデックスさせたとしても、その数をもってサイトの評価が上がることはないのです。

参考:低品質ページを大量生産しても検索エンジンの評価は上がらない、高品質コンテンツだけを作る | 海外SEO情報ブログ

参考:Does a site rank better if it has a lot of indexed pages?- YouTube

ですから、インデックスの前にサイト内のコンテンツを見直し、質の高い記事を多く作ることをまずは意識しましょう。質の高いコンテンツができたら、それらをインデックスしていくという流れで進めましょう。SEOは何よりも質の高いコンテンツありきです。「インデックスさえすれば検索順位が上がる」というような魔法は存在しません。

あえてインデックスさせない方法も

質が高いとは言えないページがあるが、すぐにリライトできないときはどうすればいいのでしょうか。実は特定のページをクローラーのクロール対象から除外してもらう方法があります。

noindex(ノーインデックス)というタグを使用するのです。noindexタグが入ったページは、クローラーが巡回してもインデックスされず、検索結果に表示されることはありません。質の高いページだけで、Webサイトが評価されることになります。

まとめ

インデックスとは公開したWebページが検索エンジンのデータベースに登録され、検索結果に表示される状態になることを指します。

SEOの基礎中の基礎になる部分ではありますが、ページ数の多いサイトなどはインデックスされないという課題も頻出します。

こうしたクロール、インデックス周りなどでお困りごとがございましたら、弊社にぜひご相談ください。

集客・コンバージョン数を増やしたい方へ